한줄요약

- UNet 사이사이에 Attention module 넣어서 성능 올리고 계산량 줄인 아키텍쳐 논문

3줄요약

- Non-overlapping window based attention module 도입하고

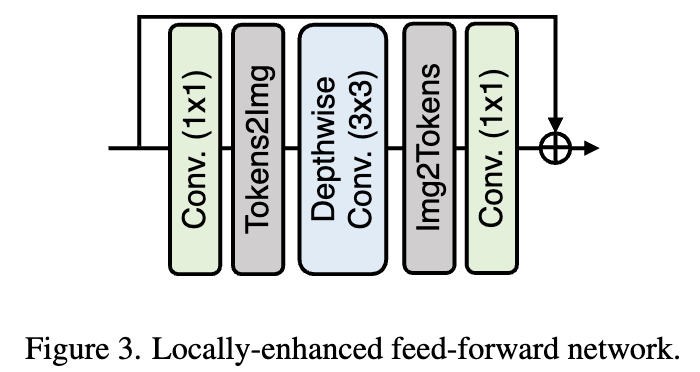

- attention block 마지막에서 feed-forward layer를 image restoration task의 특성을 고려해 2D reshape-conv-flatten 연산을 추가함

- learnable multi-scale restoration modulator 라는걸 추가했는데 단순히 각 레이어에 adding 되는 텐서임 근데 성능향상이 있다고 함